บทความนี้ เราจะพักการเขียน Prompt ไว้สักครู่ แล้วมานำเสนอการเปรียบเทียบ AI ในอีกมุมหนึ่งคือ

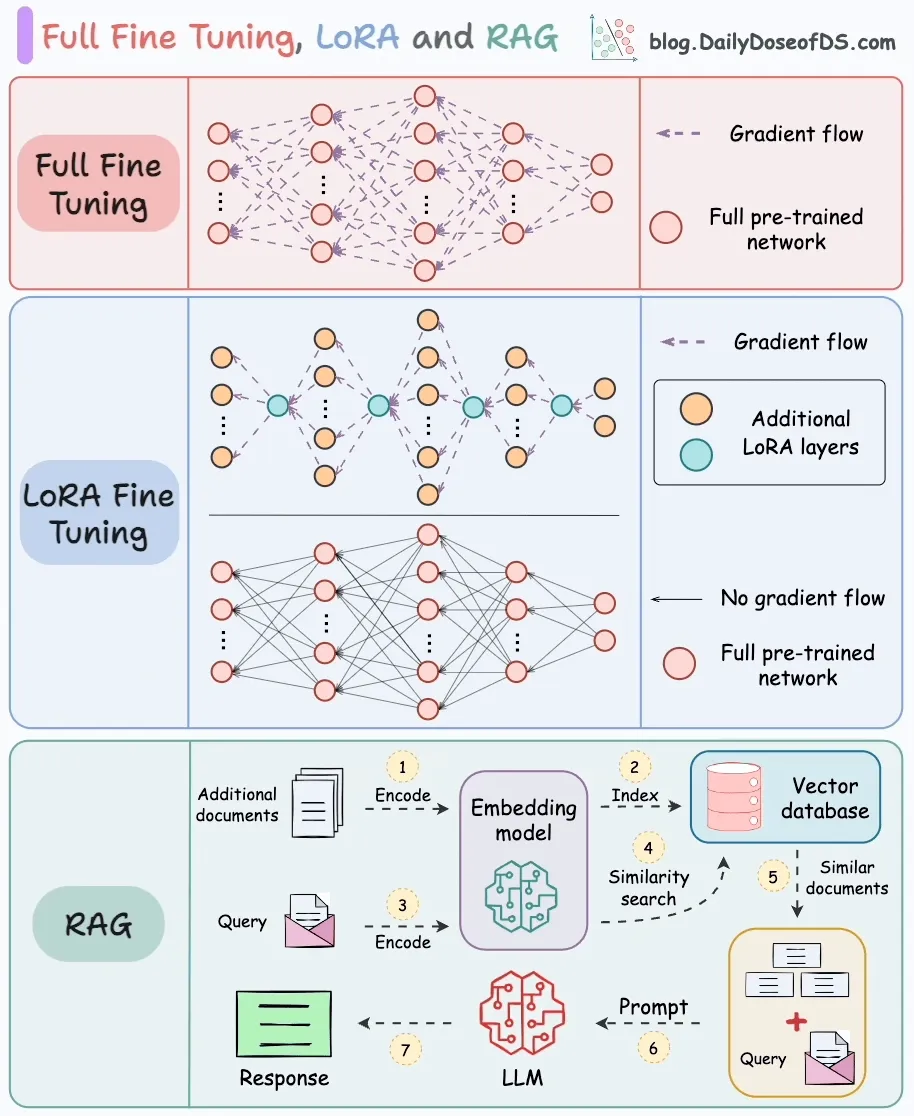

- เปรียบเทียบ RAG, LoRA และ Fine-Tuning

- เปรียบเทียบ ความสามารถในการเปรียบเทียบ (เอ๊ะ) ตามโจทย์ข้อ 1 ของ AI 5 เจ้าใหญ่ ๆ คือ ChatGPT / Gemini / Qwen / DeepSeek / Grok

เราจะไม่มีการให้คะแนน แต่จะนำเสนอผลของการวิเคราะห์ออกมาเป็นผลการเปรียบเทียบโดยใช้ Prompt เดียวกัน คือ

“ช่วยเปรียบเทียบ RAG, LoRA และ Fine-Tuning พร้อมตัวอย่างการใช้งาน”

chatGPT

ผลการเปรียบเทียบ AI ของ ChatGPT แสดงผลออกมาในการเปรียบเทียบแบบตาราง และสรุปในตอนท้าย เช่นที่เคย ๆ

เปรียบเทียบ RAG, LoRA และ Fine-Tuning พร้อมตัวอย่างการใช้งาน

| เทคโนโลยี | คำอธิบาย | ข้อดี | ข้อเสีย | ตัวอย่างการใช้งาน |

|---|---|---|---|---|

| RAG (Retrieval-Augmented Generation) | ใช้ข้อมูลจากภายนอก เช่น ฐานข้อมูล หรือเอกสาร มาช่วยเพิ่มข้อมูลในการตอบคำถามแบบเรียลไทม์ | – ไม่ต้องปรับโมเดล – อัปเดตข้อมูลได้ง่าย – ใช้ทรัพยากรน้อย | – ขึ้นกับคุณภาพข้อมูลที่ดึงมา – อาจมี latency | – ระบบถาม-ตอบเอกสารภายในบริษัท – Chatbot ที่ต้องใช้ข้อมูลล่าสุด เช่น ข่าวสาร หรือข้อมูลลูกค้า |

| LoRA (Low-Rank Adaptation) | ปรับค่าบางพารามิเตอร์ของโมเดลหลักแทนการอัปเดตทั้งหมด เพื่อลดการใช้ทรัพยากร | – ใช้ทรัพยากรน้อยกว่าการ Fine-Tuning เต็มรูปแบบ – ฝึกโมเดลได้เร็ว – ใช้กับหลายโดเมนได้ง่าย | – ไม่สามารถเปลี่ยนแปลงพฤติกรรมหลักของโมเดลได้มากนัก | – ปรับ GPT ให้เข้าใจศัพท์เฉพาะของอุตสาหกรรม – ฝึกโมเดลให้เขียนโค้ดในสไตล์เฉพาะของบริษัท |

| Fine-Tuning | ปรับค่าพารามิเตอร์ทั้งหมดของโมเดลโดยใช้ชุดข้อมูลใหม่เพื่อให้โมเดลเรียนรู้สิ่งใหม่ | – ปรับแต่งพฤติกรรมโมเดลได้อย่างสมบูรณ์ – รองรับงานเฉพาะทางได้ดีที่สุด | – ใช้ทรัพยากรสูงมาก – ต้องมีข้อมูลที่ดีและเพียงพอ | – โมเดลวิเคราะห์เอกสารทางกฎหมาย – โมเดลสร้างเนื้อหาที่มีสไตล์เฉพาะ เช่น บทความโฆษณา |

สรุปผลการเปรียบเทียบ AI

- ถ้าต้องการให้โมเดลใช้งานข้อมูลล่าสุดหรือข้อมูลเฉพาะที่ไม่ต้องการเปลี่ยนพฤติกรรมของโมเดล → RAG

- ถ้าต้องการปรับแต่งโมเดลบางส่วนให้เข้าใจงานเฉพาะ แต่ไม่ต้องใช้ทรัพยากรมาก → LoRA

- ถ้าต้องการปรับโมเดลให้ทำงานเฉพาะทางโดยเปลี่ยนพฤติกรรมทั้งหมด → Fine-Tuning

ต้องการรายละเอียดเพิ่มเติมเกี่ยวกับการใช้งานจริงไหม? 😊

แต่ที่น่าจะไม่เหมือนใครเจ้าไหนก็คงจะเป็นนำเสนอการเปรียบเทียบกับเจ้าอื่น ๆ ให้เห็น ๆ กันเลย เราลองดูผลเจ้าอื่นสักเจ้า

ลองดูของ Sider Fusion

Sider Fusion

แน่นอน! มาลองเปรียบเทียบ RAG (Retrieval-Augmented Generation), LoRA (Low-Rank Adaptation) และ Fine-Tuning กันดีกว่า พร้อมตัวอย่างการใช้งานของแต่ละวิธี

1. RAG (Retrieval-Augmented Generation)

แนวทาง: RAG เป็นวิธีที่รวมการค้นหาข้อมูลจากฐานข้อมูลภายนอกเข้ากับการสร้างข้อความโดยโมเดล AI เพื่อเพิ่มความถูกต้องและความหลากหลายในการสร้างเนื้อหา โดย RAG จะทำการค้นหาข้อมูลที่เกี่ยวข้องก่อนจากฐานข้อมูล แล้วนำข้อมูลนั้นมาสร้างเนื้อหา

ตัวอย่างการใช้งาน:

- ในการตอบคำถามจากฐานข้อมูลขนาดใหญ่ เช่น ระบบถามตอบที่ต้องให้ข้อมูลจากแหล่งข้อมูลภายนอก เช่น Wikipedia หรือเอกสารอื่น ๆ

- ในการสร้างบทความหรือรายงานที่ต้องการข้อมูลอัปเดตล่าสุด โดย RAG จะค้นหาข้อมูลที่เกี่ยวข้องแล้วสร้างเนื้อหาจากข้อมูลที่ค้นพบ

2. LoRA (Low-Rank Adaptation)

แนวทาง: LoRA เป็นวิธีที่ใช้ในการปรับแต่งโมเดลใหญ่ โดยใช้พารามิเตอร์น้อยกว่าในกระบวนการฝึกอบรม ซึ่งช่วยให้การปรับแต่งมีความรวดเร็วขึ้นและลดการใช้ทรัพยากร ในขณะที่สามารถรักษาความสามารถของโมเดลหลักไว้

ตัวอย่างการใช้งาน:

- ในการสร้างแอปพลิเคชันเฉพาะทาง เช่น การสร้างโมเดลสำหรับการวิเคราะห์ทางการแพทย์ที่ใช้ข้อมูลจากโมเดลใหญ่เช่น GPT แต่ปรับแต่งให้เหมาะสมกับบริบททางการแพทย์โดยใช้ LoRA

- ปรับโมเดลสำหรับการทำ sentiment analysis ในบริบทของภาษาไทย โดยลดขนาดข้อมูลที่ต้องฝึกอบรม

3. Fine-Tuning

แนวทาง: Fine-Tuning เป็นกระบวนการที่นำโมเดลที่ฝึกมาแล้ว (pre-trained model) มาปรับแต่งหรือฝึกเพิ่มเติมโดยใช้ข้อมูลชุดใหม่ ซึ่งทำให้โมเดลสามารถทำงานได้ดีขึ้นในงานเฉพาะทาง

ตัวอย่างการใช้งาน:

- ปรับโมเดลภาษาเพื่อแปลเอกสารเฉพาะทาง เช่น แปลเอกสารกฎหมายหรืองานวิจัยจากภาษาอังกฤษเป็นภาษาไทย

- การสอนโมเดลให้เข้าใจเนื้อหาเฉพาะของอุตสาหกรรม เช่น ปรับแต่ง GPT ให้สามารถสร้างเนื้อหาการตลาดสำหรับผลิตภัณฑ์เฉพาะอย่าง เช่น เทคโนโลยีสะอาด

สรุปผลการเปรียบเทียบ AI

- RAG มุ่งเน้นการรวมการค้นหาข้อมูลเข้ากับการสร้างข้อความเพื่อให้ได้ข้อมูลที่แม่นยำและทันสมัย

- LoRA นำเสนอวิธีการปรับแต่งโมเดลแบบประหยัดทรัพยากร

- Fine-Tuning เป็นการปรับโมเดลเพื่อให้เหมาะสมกับงานเฉพาะทาง

คุณมีคำถามเพิ่มเติมเกี่ยวกับเทคนิคเหล่านี้ไหมครับ?

Gemini

การเปรียบเทียบ AI ของ Gemini ไม่เป็นตาราง แต่เป็นการนำเสนอทีละหัวข้อ

แน่นอนครับ นี่คือการเปรียบเทียบ RAG, LoRA และ Fine-Tuning พร้อมตัวอย่างการใช้งาน:

RAG (Retrieval-Augmented Generation)

- หลักการทำงาน:

- RAG คือเทคนิคที่ช่วยเพิ่มความสามารถของโมเดลภาษาขนาดใหญ่ (LLM) โดยการเชื่อมโยง LLM เข้ากับแหล่งข้อมูลภายนอก

- เมื่อผู้ใช้ป้อนคำถาม ระบบจะค้นหาข้อมูลที่เกี่ยวข้องจากแหล่งข้อมูลภายนอก (เช่น ฐานข้อมูล, เว็บไซต์)

- ข้อมูลที่ค้นพบจะถูกนำมาใช้เพื่อเสริมสร้างพรอมต์ (prompt) ที่ใช้ในการสร้างคำตอบของ LLM

- ทำให้ LLM สามารถสร้างคำตอบที่ถูกต้องและสอดคล้องกับข้อมูลล่าสุดได้มากขึ้น

- ข้อดี:

- ลดปัญหาการ “หลอน” (hallucination) ของ LLM โดยการอ้างอิงข้อมูลที่เชื่อถือได้

- สามารถปรับปรุงความถูกต้องของคำตอบโดยใช้ข้อมูลล่าสุด

- มีความยืดหยุ่นในการปรับเปลี่ยนแหล่งข้อมูล

- ตัวอย่างการใช้งาน:

- แชทบอทที่ตอบคำถามเกี่ยวกับผลิตภัณฑ์โดยอ้างอิงจากฐานข้อมูลสินค้า

- ระบบตอบคำถามทางกฎหมายโดยอ้างอิงจากฐานข้อมูลกฎหมาย

- การสร้างเนื้อหาข่าวโดยอ้างอิงจากแหล่งข่าวล่าสุด

LoRA (Low-Rank Adaptation)

- หลักการทำงาน:

- LoRA เป็นเทคนิคการปรับแต่งโมเดล LLM ที่มีประสิทธิภาพ

- แทนที่จะปรับแต่งพารามิเตอร์ทั้งหมดของ LLM, LoRA จะเพิ่มเมทริกซ์ขนาดเล็ก (low-rank matrices) เข้าไปในเลเยอร์บางส่วนของโมเดล

- จากนั้นจะทำการปรับแต่งเฉพาะเมทริกซ์ขนาดเล็กเหล่านี้ ทำให้ใช้ทรัพยากรน้อยกว่าการปรับแต่งทั้งหมด

- ข้อดี:

- ใช้ทรัพยากรน้อยกว่า Fine-Tuning แบบเต็มรูปแบบ

- ปรับแต่งได้เร็วกว่า

- สามารถปรับแต่งโมเดลให้เข้ากับงานเฉพาะด้านได้

- ตัวอย่างการใช้งาน:

- ปรับแต่งโมเดล LLM ให้สร้างบทสนทนาที่เป็นธรรมชาติมากขึ้นสำหรับแชทบอท

- ปรับแต่งโมเดลให้สร้างเนื้อหาที่มีรูปแบบเฉพาะ เช่น บทกวี หรือสคริปต์

- การปรับแต่งโมเดลเพื่อสร้างโค้ดโปรแกรมในภาษาเฉพาะ

Fine-Tuning

- หลักการทำงาน:

- Fine-Tuning คือการนำโมเดล LLM ที่ผ่านการฝึกมาเบื้องต้น (pre-trained model) มาปรับแต่งเพิ่มเติมด้วยข้อมูลเฉพาะด้าน

- กระบวนการนี้จะปรับเปลี่ยนพารามิเตอร์ทั้งหมดของโมเดลเพื่อให้โมเดลสามารถทำงานได้ดีขึ้นในงานเฉพาะด้าน

- ข้อดี:

- สามารถปรับแต่งโมเดลให้มีความแม่นยำสูงในงานเฉพาะด้าน

- สามารถปรับแต่งโมเดลให้เข้าใจภาษาและบริบทเฉพาะด้านได้ดีขึ้น

- ข้อเสีย:

- ใช้ทรัพยากรมาก (ทั้งเวลาและค่าใช้จ่าย)

- ต้องใช้ข้อมูลจำนวนมากในการฝึก

- ตัวอย่างการใช้งาน:

- ปรับแต่งโมเดล LLM ให้วิเคราะห์ความรู้สึกของลูกค้าในรีวิวสินค้า

- ปรับแต่งโมเดลให้แปลภาษาในบริบทเฉพาะด้าน เช่น การแพทย์ หรือกฎหมาย

- การปรับแต่งโมเดลเพื่อสร้างเนื้อหาทางการตลาดให้ตรงกับกลุ่มเป้าหมาย

สรุป

- RAG เหมาะสำหรับการเพิ่มความถูกต้องและความทันสมัยของคำตอบโดยอ้างอิงข้อมูลภายนอก

- LoRA เหมาะสำหรับการปรับแต่งโมเดลให้เข้ากับงานเฉพาะด้านโดยใช้ทรัพยากรน้อย

- Fine-Tuning เหมาะสำหรับการปรับแต่งโมเดลให้มีความแม่นยำสูงในงานเฉพาะด้าน แต่ต้องใช้ทรัพยากรมาก

หวังว่าข้อมูลนี้จะเป็นประโยชน์นะครับ

qwenlm

การเปรียบเทียบของ Qwen (2.5-Max) ให้ผลใกล้เคียงกับ Gemini แต่ว่าช่วงท้าย ๆ มีตารางมาให้เล็ก ๆ

การเปรียบเทียบ RAG (Retrieval-Augmented Generation) , LoRA (Low-Rank Adaptation) และ Fine-Tuning เป็นเรื่องสำคัญสำหรับผู้ที่ต้องการปรับแต่งโมเดลภาษาขนาดใหญ่ (LLM) ให้เหมาะสมกับงานเฉพาะทาง โดยแต่ละวิธีมีข้อดีและข้อเสียแตกต่างกันตามลักษณะของงานและความต้องการในการใช้งาน มาดูรายละเอียดและตัวอย่างการใช้งานของแต่ละวิธี:

1. RAG (Retrieval-Augmented Generation)

แนวคิด:

RAG เป็นเทคนิคที่ผสมผสานระหว่างการสร้างข้อความจากโมเดลภาษา (Generation) กับการค้นหาข้อมูลจากแหล่งข้อมูลภายนอก (Retrieval) เช่น เอกสารหรือฐานข้อมูล เพื่อช่วยให้โมเดลมีข้อมูลที่แม่นยำและตรงประเด็นมากขึ้น

ข้อดี:

- ไม่ต้อง Fine-Tune : RAG ไม่จำเป็นต้องปรับแต่งโมเดลหลัก (pre-trained model) เพราะใช้วิธีการค้นหาข้อมูลจากแหล่งข้อมูลภายนอก

- ข้อมูลที่เป็นปัจจุบัน : สามารถนำข้อมูลใหม่ๆ จากแหล่งข้อมูลภายนอกมาใช้งานได้โดยไม่ต้องเทรนโมเดลใหม่

- เหมาะกับงานที่ต้องการความแม่นยำสูง : เช่น การตอบคำถามเชิงข้อเท็จจริง (Fact-based QA)

ข้อเสีย:

- ประสิทธิภาพอาจลดลง : หากฐานข้อมูลที่ใช้ค้นหามีขนาดใหญ่เกินไปหรือไม่มีโครงสร้างที่ดี อาจทำให้ระบบทำงานช้า

- พึ่งพาแหล่งข้อมูลภายนอก : หากแหล่งข้อมูลไม่ครบถ้วนหรือไม่ถูกต้อง คำตอบที่ได้อาจไม่น่าเชื่อถือ

ตัวอย่างการใช้งาน:

- Chatbot ที่ตอบคำถามเกี่ยวกับบริษัท : RAG สามารถใช้ในการตอบคำถามเกี่ยวกับนโยบายบริษัทหรือข้อมูลผลิตภัณฑ์ โดยดึงข้อมูลจากเอกสารภายในองค์กร เช่น คู่มือพนักงาน หรือเว็บไซต์ของบริษัท

- ระบบค้นหาข้อมูลทางการแพทย์ : RAG สามารถใช้ในการตอบคำถามเกี่ยวกับอาการโรคหรือการรักษา โดยดึงข้อมูลจากบทความวิชาการหรือฐานข้อมูลทางการแพทย์

2. LoRA (Low-Rank Adaptation)

แนวคิด:

LoRA เป็นเทคนิคที่ใช้ในการปรับแต่งโมเดลภาษาขนาดใหญ่โดยการเพิ่ม “low-rank matrices” ลงไปในชั้นของโมเดลแทนที่จะปรับแต่งพารามิเตอร์ทั้งหมด ซึ่งช่วยลดการใช้ทรัพยากรและเวลาในการเทรน

ข้อดี:

- ประหยัดทรัพยากร : LoRA ใช้พารามิเตอร์เพิ่มเติมเพียงเล็กน้อย (low-rank matrices) ทำให้การปรับแต่งโมเดลใช้พลังงานและหน่วยความจำน้อยกว่าการ Fine-Tuning แบบเต็ม

- เร็วกว่า Fine-Tuning : เนื่องจาก LoRA ปรับแต่งเฉพาะบางส่วนของโมเดล จึงใช้เวลาเทรนน้อยกว่า

- ยังคงรักษาความสามารถของโมเดลหลัก : LoRA ไม่เปลี่ยนแปลงพารามิเตอร์ของโมเดลหลัก ทำให้โมเดลยังคงรักษาความสามารถเดิมไว้ได้

ข้อเสีย:

- อาจไม่เหมาะกับงานที่ซับซ้อนมาก : ในกรณีที่งานต้องการการปรับแต่งโมเดลแบบเต็ม LoRA อาจไม่เพียงพอ

- ต้องออกแบบ low-rank matrices ให้เหมาะสม : อาจต้องทดลองหลายครั้งเพื่อหาขนาด rank ที่เหมาะสมสำหรับงานเฉพาะ

ตัวอย่างการใช้งาน:

- ปรับแต่งโมเดลสำหรับงานเขียนบทสนทนา : LoRA สามารถใช้ปรับแต่งโมเดลให้เขียนบทสนทนาในสไตล์เฉพาะ เช่น การเขียนบทสนทนาในเกมหรือภาพยนตร์ โดยไม่ต้องเทรนโมเดลทั้งหมด

- ปรับแต่งโมเดลสำหรับงานแปลภาษา : LoRA สามารถใช้ปรับแต่งโมเดลแปลภาษาให้เหมาะสมกับภาษาหรือสำนวนเฉพาะ เช่น การแปลภาษาในบริบทของกฎหมายหรือวิทยาศาสตร์

3. Fine-Tuning

แนวคิด:

Fine-Tuning เป็นกระบวนการปรับแต่งโมเดลภาษาขนาดใหญ่โดยการเทรนโมเดลด้วยข้อมูลเฉพาะทาง (domain-specific data) เพื่อให้โมเดลสามารถทำงานได้ดีในงานเฉพาะ เช่น การแปลภาษา การสร้างข้อความ หรือการตอบคำถาม

ข้อดี:

- ประสิทธิภาพสูง : Fine-Tuning สามารถปรับแต่งโมเดลให้มีประสิทธิภาพสูงในงานเฉพาะทางได้

- เหมาะกับงานที่ซับซ้อน : Fine-Tuning สามารถปรับแต่งโมเดลให้ทำงานได้ดีในงานที่ต้องการความแม่นยำสูง เช่น การแปลภาษาหรือการสร้างข้อความเชิงเทคนิค

ข้อเสีย:

- ใช้ทรัพยากรมาก : Fine-Tuning ต้องใช้พลังงานและหน่วยความจำจำนวนมาก เนื่องจากต้องปรับแต่งพารามิเตอร์ทั้งหมดของโมเดล

- เสี่ยงต่อการลืมข้อมูลเดิม (Catastrophic Forgetting) : เมื่อ Fine-Tuning โมเดล อาจทำให้โมเดลลืมความสามารถเดิมที่เคยมี ทำให้ต้องใช้เทคนิคเสริม เช่น Multi-task Learning

ตัวอย่างการใช้งาน:

- การแปลภาษาเฉพาะทาง : Fine-Tuning สามารถใช้ปรับแต่งโมเดลแปลภาษาให้เหมาะสมกับภาษาเฉพาะ เช่น การแปลภาษาในบริบทของกฎหมายหรือวิทยาศาสตร์

- การสร้างข้อความเชิงเทคนิค : Fine-Tuning สามารถใช้ปรับแต่งโมเดลให้สร้างข้อความเชิงเทคนิค เช่น การเขียนรายงานทางการแพทย์หรือการเขียนโค้ดโปรแกรม

สรุปการเปรียบเทียบ:

| วิธี | ความซับซ้อนในการเทรน | การใช้ทรัพยากร | ความสามารถในการปรับแต่ง | ตัวอย่างการใช้งาน |

|---|---|---|---|---|

| RAG | ต่ำ | ต่ำ | สูง (พึ่งพาแหล่งข้อมูล) | Chatbot ตอบคำถามเกี่ยวกับบริษัท, ระบบค้นหาข้อมูลทางการแพทย์ |

| LoRA | กลาง | ต่ำ | กลาง | ปรับแต่งโมเดลสำหรับงานเขียนบทสนทนา, งานแปลภาษา |

| Fine-Tuning | สูง | สูง | สูง | การแปลภาษาเฉพาะทาง, การสร้างข้อความเชิงเทคนิค |

สรุป:

- หากคุณต้องการโมเดลที่สามารถตอบคำถามได้แม่นยำโดยไม่ต้องปรับแต่งโมเดลเอง RAG เป็นตัวเลือกที่ดี

- หากคุณต้องการปรับแต่งโมเดลให้เหมาะสมกับงานเฉพาะทางแต่ไม่อยากใช้ทรัพยากรเยอะ LoRA เป็นตัวเลือกที่สมดุล

- หากคุณต้องการโมเดลที่มีประสิทธิภาพสูงสุดในงานเฉพาะทางและพร้อมที่จะลงทุนทรัพยากร Fine-Tuning เป็นทางเลือกที่เหมาะสม

deepseek

ผลการเปรียบเทียบ AI ของ DeepSeek ออกมาค่อนข้างสั้น และไม่เป็นตาราง ไม่เปรียบเทียบข้อดี ข้อเสีย เหมือนเจ้าอื่น ๆ

การเปรียบเทียบระหว่าง RAG (Retrieval-Augmented Generation), LoRA (Low-Rank Adaptation), และ Fine-Tuning มีดังนี้:

1. RAG (Retrieval-Augmented Generation)

RAG เป็นโมเดลที่ผสมผสานระหว่างการค้นหาข้อมูล (Retrieval) และการสร้างข้อความ (Generation) โดยใช้ฐานข้อมูลภายนอกเพื่อเพิ่มความแม่นยำและความเกี่ยวข้องของข้อมูลที่สร้างขึ้น

ตัวอย่างการใช้งาน:

- ระบบตอบคำถาม: เมื่อมีคำถามเข้ามา RAG จะค้นหาข้อมูลที่เกี่ยวข้องจากฐานข้อมูลก่อน แล้วจึงสร้างคำตอบที่แม่นยำและมีเนื้อหาสมบูรณ์

- การวิจัย: ใช้ในการค้นหาและสรุปข้อมูลจากเอกสารวิชาการจำนวนมาก

2. LoRA (Low-Rank Adaptation)

LoRA เป็นเทคนิคการปรับปรุงโมเดลขนาดใหญ่โดยการเพิ่มเลเยอร์ที่มีพารามิเตอร์น้อยลง (low-rank) เพื่อปรับปรุงประสิทธิภาพในงานเฉพาะทางโดยไม่ต้องปรับปรุงโมเดลทั้งหมด

ตัวอย่างการใช้งาน:

- การปรับปรุงโมเดลภาษา: ปรับปรุงโมเดลภาษาเช่น GPT-3 ให้ทำงานได้ดีขึ้นในงานเฉพาะทางเช่นการแปลภาษา หรือการวิเคราะห์ความรู้สึก

- การประหยัดทรัพยากร: ลดการใช้ทรัพยากรในการฝึกโมเดลใหม่โดยการปรับปรุงเฉพาะส่วนที่จำเป็น

3. Fine-Tuning

Fine-Tuning เป็นกระบวนการฝึกโมเดลที่ผ่านการฝึกมาแล้ว (pre-trained model) บนชุดข้อมูลเฉพาะเพื่อปรับปรุงประสิทธิภาพในงานนั้นๆ

ตัวอย่างการใช้งาน:

- การจำแนกข้อความ: ปรับปรุงโมเดลเพื่อจำแนกข้อความในหมวดหมู่เฉพาะเช่นข่าวสุขภาพหรือข่าวกีฬา

- การสร้างข้อความ: ปรับปรุงโมเดลเพื่อสร้างข้อความในสไตล์หรือเนื้อหาเฉพาะเช่นบทความวิชาการหรือบทสนทนา

สรุป

- RAG ใช้สำหรับการค้นหาและสร้างข้อความที่แม่นยำโดยใช้ฐานข้อมูลภายนอก

- LoRA ใช้สำหรับปรับปรุงโมเดลขนาดใหญ่โดยการเพิ่มเลเยอร์ที่มีพารามิเตอร์น้อยลง

- Fine-Tuning ใช้สำหรับปรับปรุงโมเดลที่ผ่านการฝึกมาแล้วให้ทำงานได้ดีขึ้นในงานเฉพาะทาง

แต่ละวิธีมีจุดเด่นและจุดด้อยต่างกัน ขึ้นอยู่กับงานและทรัพยากรที่มี

Grok

Grok ให้ผลลัพธ์ที่ค่อยข้างคล้าย Gemini และ Qwen แต่มีตารางเปรียบเทียบมาให้ประมาณหนึ่ง

ผมจะเปรียบเทียบ RAG (Retrieval-Augmented Generation), LoRA (Low-Rank Adaptation) และ Fine-Tuning ในแง่ของแนวคิด วิธีการ และตัวอย่างการใช้งานให้เข้าใจง่าย ๆ นะครับ

1. RAG (Retrieval-Augmented Generation)

แนวคิด

- RAG เป็นเทคนิคที่ผสมผสานการดึงข้อมูล (Retrieval) กับการสร้างคำตอบ (Generation) โดยโมเดลจะค้นหาข้อมูลที่เกี่ยวข้องจากแหล่งข้อมูลภายนอก (เช่น ฐานข้อมูลหรือเอกสาร) แล้วนำมาประมวลผลร่วมกับโมเดลภาษาเพื่อสร้างคำตอบที่มีความแม่นยำและบริบทมากขึ้น

- เหมาะกับงานที่ต้องการข้อมูลล่าสุดหรือข้อมูลเฉพาะเจาะจงที่ไม่อยู่ในชุดข้อมูลฝึกสอนเดิม

วิธีการ

- แบ่งเป็นสองขั้นตอน:

- Retriever: ดึงข้อมูลที่เกี่ยวข้องจากฐานข้อมูลโดยใช้คำถามหรือบริบท

- Generator: โมเดลภาษา (เช่น GPT) นำข้อมูลที่ดึงมาได้ไปสร้างคำตอบ

- ไม่ต้องปรับแต่งพารามิเตอร์ของโมเดลมากนัก เพราะอาศัยการดึงข้อมูลภายนอกเป็นหลัก

ข้อดี

- อัปเดตข้อมูลได้ง่ายโดยไม่ต้องเทรนโมเดลใหม่

- ลดการ “หลอน” (hallucination) เพราะมีข้อมูลจริงมาสนับสนุน

ข้อจำกัด

- ขึ้นอยู่กับคุณภาพของฐานข้อมูลและระบบดึงข้อมูล

- อาจช้ากว่าเทคนิคอื่นเพราะต้องค้นหาข้อมูลก่อน

ตัวอย่างการใช้งาน

- ระบบถาม-ตอบ (Q&A): เช่น สร้างแชทบอทที่ตอบคำถามเกี่ยวกับนโยบายบริษัท โดยดึงข้อมูลจากคู่มือล่าสุด

- การค้นคว้าข้อมูล: ช่วยนักวิจัยค้นข้อมูลจากเอกสารวิชาการและสรุปคำตอบ

2. LoRA (Low-Rank Adaptation)

แนวคิด

- LoRA เป็นเทคนิคที่ใช้ “ปรับแต่ง” โมเดลภาษาขนาดใหญ่โดยไม่ต้องเปลี่ยนพารามิเตอร์ทั้งหมดของโมเดล แทนที่จะ Fine-Tune ทุกชั้นของโมเดล LoRA จะเพิ่มชั้นพารามิเตอร์ขนาดเล็ก (low-rank matrices) เข้าไป แล้วปรับแต่งเฉพาะส่วนนั้น

- เหมาะกับงานที่ต้องการประหยัดทรัพยากรและปรับโมเดลให้เข้ากับงานเฉพาะ

วิธีการ

- แช่แข็ง (freeze) พารามิเตอร์ดั้งเดิมของโมเดลไว้

- เพิ่มเมทริกซ์ขนาดเล็กเข้าไปในชั้นของโมเดล (เช่น ใน Transformer) แล้วเทรนเฉพาะเมทริกซ์นั้น

- ใช้ทรัพยากรน้อยกว่า Fine-Tuning แบบเต็มรูปแบบมาก

ข้อดี

- ประหยัดหน่วยความจำและพลังงาน (เหมาะกับการเทรนบนเครื่องจำกัด)

- สามารถสลับการปรับแต่งสำหรับงานต่าง ๆ ได้ง่าย (เช่น มี LoRA หลายชุดสำหรับงานต่างกัน)

ข้อจำกัด

- ประสิทธิภาพอาจไม่เท่า Fine-Tuning แบบเต็มตัวในงานที่ซับซ้อนมาก

- ต้องออกแบบโครงสร้าง LoRA ให้เหมาะสม

ตัวอย่างการใช้งาน

- แปลภาษาเฉพาะทาง: ปรับโมเดลให้แปลศัพท์เทคนิคในวงการแพทย์ได้ดีขึ้น

- แชทบอทส่วนตัว: ปรับโมเดลให้มีบุคลิกหรือสไตล์การพูดตามที่ผู้ใช้ต้องการ โดยไม่ต้องเทรนใหม่ทั้งหมด

3. Fine-Tuning

แนวคิด

- Fine-Tuning คือการนำโมเดลที่ถูกเทรนมาก่อนแล้ว (pre-trained model) มาปรับแต่งพารามิเตอร์ทั้งหมดหรือบางส่วนด้วยชุดข้อมูลใหม่ เพื่อให้เหมาะกับงานเฉพาะเจาะจงมากขึ้น

- เหมาะกับงานที่ต้องการประสิทธิภาพสูงสุดและมีชุดข้อมูลเฉพาะที่เพียงพอ

วิธีการ

- ใช้โมเดล pre-trained (เช่น BERT, GPT) แล้วเทรนต่อด้วยชุดข้อมูลใหม่

- ปรับพารามิเตอร์ทั้งโมเดลหรือบางชั้น (ขึ้นอยู่กับทรัพยากรและเป้าหมาย)

ข้อดี

- ได้ผลลัพธ์ที่ดีที่สุดเมื่อมีข้อมูลเพียงพอ

- ปรับโมเดลให้เข้ากับงานได้ลึกซึ้ง

ข้อจำกัด

- ใช้ทรัพยากรเยอะ (ทั้งเวลาและพลังงาน)

- เสี่ยงเกิด “catastrophic forgetting” (โมเดลลืมความรู้เดิม)

ตัวอย่างการใช้งาน

- การวิเคราะห์ความรู้สึก (Sentiment Analysis): ปรับโมเดลให้วิเคราะห์รีวิวสินค้าในภาษาไทยได้แม่นยำ

- การสร้างบทความ: เทรนโมเดลให้เขียนบทความในสไตล์นักเขียนคนใดคนหนึ่ง

ตารางเปรียบเทียบ

| คุณสมบัติ | RAG | LoRA | Fine-Tuning |

|---|---|---|---|

| เป้าหมาย | เพิ่มบริบทจากภายนอก | ปรับแต่งแบบประหยัด | ปรับแต่งเต็มรูปแบบ |

| ทรัพยากรที่ใช้ | ปานกลาง | น้อย | มาก |

| การอัปเดตข้อมูล | ง่าย (เปลี่ยนฐานข้อมูล) | ปานกลาง | ยาก (ต้องเทรนใหม่) |

| ความยืดหยุ่น | สูง | ปานกลาง | ต่ำ |

| ตัวอย่างงาน | Q&A จากเอกสาร | แปลภาษาเฉพาะ | วิเคราะห์ความรู้สึก |

สรุป

- ใช้ RAG ถ้าต้องการคำตอบจากข้อมูลล่าสุดหรือ外部โดยไม่ต้องเทรนโมเดลใหม่

- ใช้ LoRA ถ้าต้องการปรับโมเดลให้เข้ากับงานเฉพาะแบบประหยัดทรัพยากร

- ใช้ Fine-Tuning ถ้ามีทรัพยากรเพียงพอและต้องการประสิทธิภาพสูงสุด

ถ้าอยากให้ขยายตัวอย่างหรือเจาะลึกส่วนไหนเพิ่ม บอกมาได้เลยครับ!

สรุปผลการเปรียบเทียบของ 5 AI โมเดล

- ถ้าต้องการให้โมเดลใช้งานข้อมูลล่าสุดหรือข้อมูลเฉพาะที่ไม่ต้องการเปลี่ยนพฤติกรรมของโมเดล → RAG

- ถ้าต้องการปรับแต่งโมเดลบางส่วนให้เข้าใจงานเฉพาะ แต่ไม่ต้องใช้ทรัพยากรมาก → LoRA

- ถ้าต้องการปรับโมเดลให้ทำงานเฉพาะทางโดยเปลี่ยนพฤติกรรมทั้งหมด → Fine-Tuning

สรุปผลการเปรียบเทียบ RAG/LoRA/Fine-Tuning

สรุปข้อดี/เสีย

- แม่นยำไม่ต้องปรับแต่ง : ถ้าต้องการให้โมเดลใช้งานข้อมูลล่าสุดหรือข้อมูลเฉพาะ อ้างอิงข้อมูลภายนอก ที่ไม่ต้องการเปลี่ยนพฤติกรรมของโมเดล → RAG

- ปรับแต่งใช้ทรัพยากรน้อย : ถ้าต้องการปรับแต่งโมเดลบางส่วนให้เข้าใจงานเฉพาะ แต่ไม่ต้องใช้ทรัพยากรมาก → LoRA

- ประสิทธิภาพสูงสุดและมีทุน : ถ้าต้องการปรับโมเดลให้ทำงานเฉพาะทาง ปรับแต่งโมเดลให้มีความแม่นยำสูงได้ โดยเปลี่ยนพฤติกรรมทั้งหมด → Fine-Tuning

สรุปข้อจำกัด

- RAG : ขึ้นอยู่กับคุณภาพของฐานข้อมูลและระบบดึงข้อมูล อาจช้ากว่าเทคนิคอื่นเพราะต้องค้นหาข้อมูลก่อน

- LoRA : ประสิทธิภาพอาจไม่เท่า Fine-Tuning แบบเต็มตัวในงานที่ซับซ้อนมาก ต้องออกแบบโครงสร้าง LoRA ให้เหมาะสม

- Fine-Tuning : ใช้ทรัพยากรเยอะ (ทั้งเวลาและพลังงาน) เสี่ยงเกิด “catastrophic forgetting” (โมเดลลืมความรู้เดิม) และ Hallucination (การหลอนของโมเดล) (คืออะไร อ่านต่อที่นี่)

ที่มา : https://blog.dailydoseofds.com/p/full-model-fine-tuning-vs-lora-vs

ทั้งหมดนี้คือการนำเสนอผลการเปรียบเทียบ AI เจ้าใหญ่ ๆ 5 เจ้า ในมุมของการเปรียบเทียบความรู้ความสามารถในการเปรียบเทียบ หรือสร้างตารางประกอบการตัดสินใจในประเด็น RAG, LoRA และ Fine-Tuning

สิ่งที่ผู้อ่านได้รับคือแน่นอน ผลการเปรียบเทียบ และความสามารถในการเปรียบเทียบของ AI ทั้ง 5 เจ้า

และสุดท้าย มีใครสังเกตุเห็นภาษาแปลก ๆ บ้าง ในเจ้าไหน…..